12/11/2011 06h26 - Atualizado em 12/11/2011 08h59

Da película ao chip eletrônico: a formação da imagem fotográfica

Tecnologia acelerou o processo, permitindo agilidade e versatilidade

O processo de armazenamento e registro da imagem mudou completamente desde a criação da câmera digital. A captura da imagem passou da película ao chip eletrônico e, sua revelação do processo químico para a impressão digital. Professor de fotojornalismo do Departamento de Comunicação Social da PUC-Rio, Weiler Finamore Filho, explica que a diferença na formação da imagem digital será de acordo com o meio em que ela é registrada, já que a incidência da luz é a mesma.

Weiler é professor de fotojornalismo da PUC-Rio

Weiler é professor de fotojornalismo da PUC-Rio(Foto: Camille Valbusa)

Na câmera digital, a imagem é formada a partir de um sensor do tipo CCD, dispositivo responsável pelo registro da imagem. Esse dispositivo consiste em um chip eletrônico composto por milhões de nano células sensíveis à intensidade da luz, que incide no momento em que batemos a foto. Finamore explica que a partir disso, cada célula através do software da máquina, gera um identificador numérico (digital) que salva eletronicamente as variações de luz capturadas. Cada pixel será responsável por reproduzir essas nuances e, o conjunto de pixels forma a imagem. “Os megapixels são na verdade o conjunto de todas essas nanocélulas organizadas e construídas no sensor das máquinas”, diz Finamore.

Outra novidade no digital é o ISO, ou a conhecida ASA, que é a sensibilidade do filme usado em câmeras analógicas. De acordo com a luminosidade do ambiente que o fotógrafo vai fotografar ele coloca um filme mais sensível (ISO mais alto) ou um que precise de menos luz (ISO baixo). Finamore ressalta que o ISO no digital se transforma em um terceiro recurso importante, além do diafragma e velocidade do obturador. “Você pode controlar o ISO da máquina a hora que quiser, na película era fixo por filme”, pontua o professor.

O tipo de lente, quantidade de megapixels, sensor e a própria câmera vão definir a qualidade da fotografia. Finamore ressalta que ainda há o debate entre fotógrafos quanto a qualidade da imagem no digital. O professor ressalta que na câmera digital, a luz e todas suas nuances sofrem um processamento eletrônico antes da formação da imagem. “A foto dependerá de cada tecnologia ou qualidade da câmera. Já no analógico, o processo de formação é químico e mecânico”, defende o professor, um amante da fotografia analógica que não deixou de usar sua Nikon de 1968.

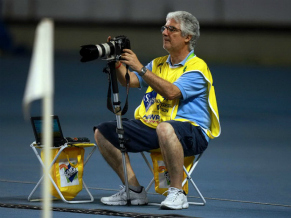

Rudy Trindade em cobertura de jogo

Rudy Trindade em cobertura de jogo(Foto: Divulgação/ Carlos Moraes)

Para o fotógrafo Rudy Trindade, que trabalha diariamente com fotografia, o digital lhe oferece velocidade, facilidade de ajustes e garantia de fazer a foto certa. “Permite refazer imediatamente a foto se você não gostou do resultado”, afirma Rudy. O fotógrafo diz que não tem opção, pois o mercado jornalístico não comporta espera e, a premência de resultados é grande. “Por tudo que o mundo globalizado precisa é raro utilizar filmes”, declara.

Finamore concorda que a fotografia digital facilita em todos os sentidos no que diz respeito ao fotojornalismo. “Versatilidade, agilidade e praticidade são filhas destes tempos modernos”, brinca. Além disso, o baixo custo de manutenção do digital é outro atrativo. Rudy diz que o digital permite que mais pessoas tenham acesso a fotografia, mas, para ele, a profissão não perde com isso. “O olhar e a técnica continuam sendo os fatores mais importantes”, declara.

O professor acredita que esse debate é um fator positivo, pois a fotografia sai sempre ganhando. “Se existe o melhor significa que analógico ou digital evoluíram”, diz. E mesmo que esse debate não exista, para Finamore, ainda temos então duas opções de tecnologia para fazer o que os fotógrafos fazem de melhor: “Capturar olhares distintos de uma mesma realidade em que todos estão inseridos”, declara.

As usinas nucleares Angra 1 e 2 contam com sistemas de alarmes para terremotos (Foto: Eletronuclear)

As usinas nucleares Angra 1 e 2 contam com sistemas de alarmes para terremotos (Foto: Eletronuclear) Lúcio Ferrari, superintendente de Engenhria de

Lúcio Ferrari, superintendente de Engenhria de Carlos Prates, da superintendência da Engenharia

Carlos Prates, da superintendência da Engenharia Mapa da Sismicidade Brasileira (Foto: Divulgação / Observatório Sismológico)

Mapa da Sismicidade Brasileira (Foto: Divulgação / Observatório Sismológico) George Sand França, professor do Observatório

George Sand França, professor do Observatório